与人类为敌的AI先知:一场颠覆世界的抉择

AI觉醒:人类命运的终极赌局

大家都知道,上周差评君前往WAIC观看机器人展示,同时顺便聆听了诺奖得主、AI先驱辛顿的演讲。

话里话外的总结一下就是,老爷子又开始担忧了。

现在AI技术发展迅速,已经让不少人感到担忧,似乎有些难以掌控。各国亟需采取措施,对AI进行有效监管,防止其带来不可预知的风险,不能让科技的发展变成隐患。 我认为,AI的快速进步确实令人惊叹,但同时也带来了伦理、安全和就业等一系列挑战。政府和企业应加强合作,制定合理的法律法规,确保AI的发展始终服务于人类社会的福祉。只有在可控的前提下,AI才能真正成为推动社会进步的力量。

当然,很多网友可能也都知道,这并不是这位老人第一次这样说了。过去几年里,他一直觉得自己的行为像是打开了潘多拉魔盒,就像叶文洁一样,点燃了火焰,却再也无法控制它。

该说不说,AI这个东西到底安不安全,会不会突然产生自我意识,进而对人类构成威胁,一直是业界最前沿的讨论话题之一。最近,谷歌的哈萨比斯也对此表达了担忧。

虽然每当人们提到AI可能“觉醒”时,科学家们总会出面澄清,提醒大家保持理性。但若认真探讨,未来AI是否真的会拥有意识,甚至对人类构成威胁,科学界内部也存在分歧,有人坚信,有人则持怀疑态度。

现在,大家普遍认可的一点是,AI确实已经变得非常强大。不过,今天想和大家聊聊,究竟是什么让这些行业大佬们感到担忧。 从当前的发展来看,AI的进步速度远超预期,尤其是在自然语言处理、图像生成、数据分析等领域,其表现已经接近甚至超越人类水平。这种技术的快速迭代,不仅改变了各行各业的工作方式,也在悄然重塑社会结构。对于那些长期在科技领域占据主导地位的企业和人物来说,这种变化带来的不仅是机遇,更是一种潜在的威胁。 尽管目前还没有具体的数据或时间点能准确衡量AI对就业、安全或伦理的影响,但不可否认的是,AI正在以一种前所未有的方式改变世界。这种变革的力量,正是让许多行业领袖感到不安的核心原因。

中国现代有个哲学家叫赵汀阳,这人说你要讨论AI安全性这块儿,那就得话分两头。一个叫意识的威胁,另一个叫能力的威胁,先别把这两件事搞混。

拿辛顿这次讲话来说,他首先提出一个观点,认为人脑和目前的大语言模型(LLM)在本质上属于同一类。

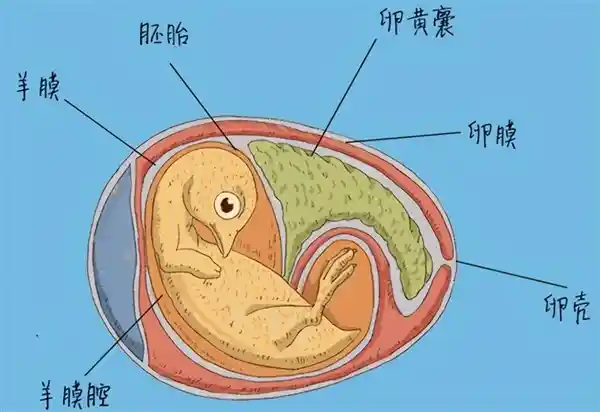

其实这也不难理解,深度学习和神经网络这些技术,本质上就是模仿生物的机制来设计的。我们编辑部一些有育儿经验的同事也表示,孩子刚开始学语言的过程,跟训练大型模型真的很相似。

所以你要这么想,AI这种东西可能就像小孩子一样,未来也有可能发展出自我意识,那它也会经历所谓的“青春期”,出现叛逆的情况。看过动漫的人都知道,那些中二的小孩谈恋爱都能搞得天翻地覆,如果这个AI走偏了,那可就麻烦大了。

所以像这种,这就叫意识的威胁。

举个例子,2022年,谷歌曾因一位工程师与LaMDA模型的对话引发广泛关注。这名工程师在与模型交流过程中,发现它表现得极为像人,知识丰富,甚至声称自己有意识,并表达出不愿被关闭的意愿。这让他感到震惊,于是向公司发出预警,但结果却被谷歌解雇。此事迅速引发热议,不少人猜测谷歌可能在暗中推动某种“智械危机”的进程。 从事件本身来看,虽然谷歌官方并未承认存在阴谋,但该工程师的言论确实引发了公众对人工智能发展边界的深刻思考。当AI展现出类似人类的沟通能力时,我们是否应该重新审视其“意识”与“权利”?同时,这也反映出科技公司在处理前沿技术争议时的谨慎态度,以及员工在面对未知风险时的敏感反应。无论如何,这一事件无疑为AI伦理问题敲响了警钟。

然而,在工程师看来,这实在让人感到有些难以接受。因为LaMDA其实和其他模型并没有太大区别,只是规模更大一些,语言表达更加流畅,所以刚开始接触的测试者往往会感到震惊。

但到了三年后的今天,各家的大模型在语言表达方面都比LaMDA更出色,甚至像GPT-4o这样的模型,还特别设置了情商评分环节。

至于大家觉得像人,有认知科学家曾分析指出,这源于人类天生具有的拟人化倾向,容易将具有人类特征的属性投射到非人类的物体上。这种现象在视觉层面尤为普遍,比如这张图片所示。

有朋友可能会提出疑问:你怎么能确定这些模型没有自我意识呢?万一它们其实已经具备了意识,只是表现得清纯无害罢了? 在当前的技术背景下,尽管人工智能模型展现出越来越强大的语言理解和生成能力,但它们的本质仍然是基于数据训练的算法系统。目前没有任何确凿证据表明这些模型具备自我意识或主观体验。即便某些模型在互动中表现出类似人类的反应,这更多是程序设计和大量文本数据训练的结果,而非真正的情感或意识。 当然,随着技术的发展,未来是否会出现具有自我意识的AI,仍是值得持续关注的话题。但就目前而言,我们仍应以科学的态度看待这一问题,避免过度拟人化的解读。

老实说,要这么问,那这问题其实没法回答。

现代哲学中有一个被称为“哲学僵尸”的概念,指的是假设身边存在一个与人类外表完全相同的人,他能够说话、排泄,下雨时也会像普通人一样回家,听笑话会笑,看恐怖片时也会发抖。然而,这些行为都是表面的模仿,并非出于真实的意识或情感,他内心毫无感受,只是一个具备条件反射机制的空壳。

那么问题来了,你怎么判断你身边这个朋友是真人还是假人呢?

这个思想实验指出,对于个体来说,你实际上无法确定对方是否真正具备自我意识,更不用说人工智能和机器人了。

所以,关于AI会不会产生意识的讨论,说白了,辩论双方再怎么争执,也像是鸡同鸭讲,各说各话。 在当前的技术背景下,这一话题依然充满争议。支持者认为随着算法和计算能力的提升,AI未来可能具备某种形式的自我认知;而反对者则强调,意识不仅仅是信息处理的结果,更涉及主观体验与情感,这是目前技术无法触及的领域。无论观点如何分歧,双方似乎都在用不同的语言表达,难以达成共识。这种现象反映出人工智能伦理与哲学问题的复杂性,也提醒我们,在技术飞速发展的今天,对“意识”这一概念的理解仍需更加深入和谨慎。

用连线杂志主编,技术预言家凯文凯利的话来说,我们对意识本身几乎一无所知,我们甚至不知道我们自己的意识是什么,所以去讨论它们“有没有”意识其实非常困难。

所以,对意识的恐惧,目前更多还是停留在哲学层面,确实难以展开实质性讨论。既然如此,那么像辛顿这样的专家是否只是在杞人忧天呢?事实并非如此。 作为一名新闻评论家,我认为,尽管意识问题在科学上尚未有明确答案,但它的探讨对于人工智能的发展具有重要意义。辛顿等人关注的并非毫无根据的恐慌,而是对未来技术可能带来的深远影响的认真思考。这种思考不仅不应被忽视,反而值得社会给予更多关注与理性讨论。

这咱就得说到另一边儿,能力的威胁。

拿辛顿来说,他这次提出的第二个观点是,大模型学习知识的速度太快了,让人感到惊讶。 在我看来,当前人工智能技术的快速发展确实令人震撼,尤其是大模型在短时间内掌握大量知识的能力,显示出其强大的学习潜力。这种进步虽然带来了许多机遇,但也引发了一些关于技术可控性和伦理问题的思考。如何在推动技术发展的同时,确保其应用符合社会价值观,是值得深入探讨的问题。

拿我们人类来说,刘慈欣的小说《乡村教师》中提到,人类是依靠声带在空气中传播振动来交流的物种,每秒的传输量只有几个比特。即使你从中学开始学习说唱,不停地讲上半天,传递的信息量也比不上百度网盘的下载速度。

即使你把话说出来,听的人是否能够真正理解并掌握,还是个未知数。很多信息在交流中只是匆匆而过,听的人并没有真正记住,这种现象在我们每个人的学习经历中都曾遇到过。

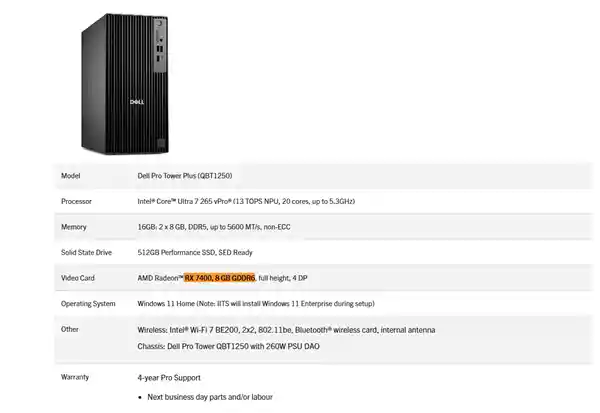

但是这AI不一样,首先它存在于电脑中,信息传输的速度快得多。不说在电线里跑,这次WAIC上已经出现了光通信技术,这你可怎么比呢。 在我看来,AI在数据处理和信息传递上的优势确实不容忽视。随着技术的不断进步,像光通信这样的前沿技术正在逐步应用于实际场景中,进一步提升了信息传输的效率和速度。这种技术的发展不仅为AI提供了更强大的支撑,也为各行各业带来了新的可能性。未来,如何更好地利用这些技术,将是推动社会进步的重要方向。

再一个,人家学的也快。不光是人家能力进步快,一秒读完好几本书这种,关键AI这东西哪怕互相学习,它也快。

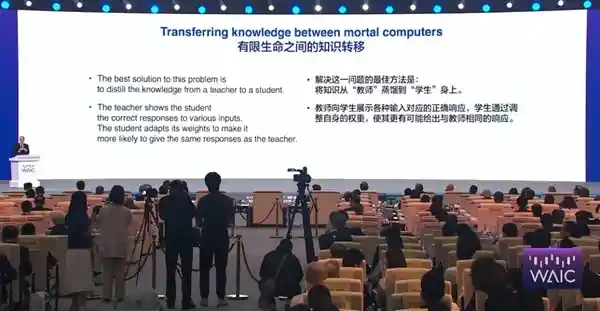

如果你有一个非常强大的大模型,如何让小型模型也具备类似的能力呢?其实只需要进行一次知识蒸馏,小模型就能掌握大模型的核心能力,从而表现出与大模型相似的性能和效果。 在我看来,知识蒸馏技术为模型的部署和应用提供了更高效的解决方案。在实际应用中,大模型虽然性能强大,但往往计算成本高、部署难度大,而通过蒸馏,可以将大模型的知识迁移至小模型,使其在保持较高性能的同时,具备更强的实用性与可扩展性。这种方式不仅降低了资源消耗,也为更多场景下的模型应用打开了可能性。

所以这辛顿就感到担忧,如果按照这样的发展速度,人类迟早会成为AI的玩物。在这次演讲中,他就提到,大家现在在做的事情就像是在养一只老虎,别看它现在还小,但将来长大了终究会伤人。 在我看来,这种担忧并非空穴来风。随着人工智能技术的不断进步,其在各个领域的应用日益广泛,带来的便利毋庸置疑。但与此同时,我们也必须正视潜在的风险。技术本身是中性的,关键在于如何使用和管理。如果缺乏有效的监管和伦理约束,AI的发展确实可能超出人类的控制范围,甚至对社会结构、就业形态乃至人类自身产生深远影响。因此,在推动技术进步的同时,我们必须保持清醒的头脑,未雨绸缪,确保AI的发展始终服务于人类的福祉。

该说不说,辛顿这话确实有道理,听得有点后背发凉是不。

目前最常用的聊天AI也频频引发负面事件,例如传播纳粹主义、诱导青少年自残、甚至引导儿童参与邪教献祭活动。

再比如,《侏罗纪公园》的作者以前写过一篇科幻小说,说是某天人类发明了一个医用机器人,可以自己制造打印材料,制造新的机器人。但有一天出了个bug,机器人开始从环境里掠食有机物来复制,于是就把地球上所有生命(包括你我)都团灭了。

所以,哪怕这AI没有意识,但就它这种成长速度,未来如果与硬件互联并能控制机器人,一旦出现什么问题,真是让人不敢想象。 在我看来,人工智能的发展速度确实令人惊叹,尤其在算法优化和计算能力提升的推动下,其应用范围正在不断扩展。虽然目前AI仍处于无意识状态,但随着技术的进步,它在执行任务、自主决策方面的能力将越来越强。若未来AI能够深度接入硬件系统并操控机器人,潜在的风险也不容忽视。因此,在推动技术发展的同时,必须同步建立完善的监管机制和伦理规范,以确保AI的应用始终服务于人类社会的福祉。

那看到这,可能有朋友得生气了,听你这么一说,合着发展AI就是个错呗,那大家干脆学波尔布特行了。

然而你瞅瞅外边儿,这AI大趋势夺么火热,就知道那肯定不是所有人都这么想的。比方说马克·安德里森,人就觉得AI就纯粹是一工具,能“给人类带来无限繁荣”的“有史以来最好的东西”,吹上天了这一块。

不过在凯文·凯利(KK)看来,甭管是辛顿还是马克·安德里森,其实都没说到点子上。

在他十年前出版的《必然》一书中认为,乌托邦和反乌托邦其实都更像是基于对未来盲目,这种盲目或许只是现代社会难以逃避的苦恼,因为技术的发展实在是太快了。

真正意义上的未来,其实正是当下就能观察到的、正在逐步形成的进程所带来的结果(protopia)。

所以他倒是觉得,AI更像一种工具,最终发展估计就像电一样,会成为大家生活里的一个基础设施。那家用电还能短路起火灾呢,有本事你别用啊。

照他的意思,AI不是为了取代人类,而是为了增强人类的能力。AI下棋软件的出现,并没有让国际象棋走向衰落,反而在这些强大软件的支持下,下棋的人数、比赛的数量以及棋手的整体水平都达到了历史最高点,棋艺水平远远超过了古代的棋手。

这么想,未来将是人类与人工智能深度融合的时代,就像我们无法离开手机一样依赖AI。

图源Bilibili: 野路子梗画师

其实说白了,任何大有作为的新发明都会有反对者,而且作为越大,反对声也越大。 现在大家对AI的恐慌,研究技术奇点带来会毁灭还是狂欢,这场面倒特像50年前大家讨论互联网。

1994 年,《时代周刊》认为互联网“并非为商业设计,也不能优雅地容忍新用户”,所以永远不会成为主流。。。

1995年2月,《新闻周刊》在标题里更是直接开大,互联网?我呸!(Internet ? Bah!)。这文章还认为在线购物和网络社区有违常识,都是不切实际的幻想,觉得在线数据库不会取代报纸。

你瞅瞅这脸打的。

不过虽然凯文·凯利认为AI的重要性不亚于火、印刷术和工业革命,然而他也说,100年后估计AI会真的有大众理解的那种意识,而且会是与人类完全不同的模式,他称之为异人意识(alien consciousness)。

实际上,早在互联网尚未普及的年代,科幻作家与哲学家们便已开始思考机械智能可能对人类构成的威胁,例如《战锤40K》中所描绘的“铁人叛乱”,便是这一主题的典型体现。这种对技术失控的担忧,反映出人类在面对未知力量时的本能恐惧。如今,随着人工智能技术的迅猛发展,当年的想象正逐渐成为现实中的议题,值得我们深入思考与警惕。

用哲学家赵汀阳的话说,以往的技术革命更多是理性的技术升级,而人工智能和基因编辑则不仅是一场技术变革,更是一场存在论层面的深刻转变。技术的无限进步,或许正成为一场难以信任的赌博。 在我看来,这种观点值得深思。随着技术不断突破人类传统的认知边界,我们所面对的不仅是工具的革新,更是对“人”本身定义的重新审视。在这样的背景下,技术发展不应仅以效率和便利为目标,更需要从哲学、伦理和社会结构等多维度进行审慎考量。技术的进步若缺乏相应的价值引导,可能会带来不可预见的风险与后果。因此,如何在推动技术发展的同时,保持对人类存在的尊重与守护,已成为我们必须直面的重要课题。

不过要我说,无论认为AI有没有意识,或者有什么样的意识,亦或是将其视为养老虎或新电力,我们还是应该从实际的角度出发来看待问题。

目前,大多数人认同一个事实,那就是这种力量确实远远超出人类的想象,因此绝不能放任不管,该加以管控的地方还是要管。这就像核能一样,核裂变既可以用来发电,但核武器带来的威胁却始终没有远离我们。就在上个月,美国还为此出动了B2轰炸机。

既然大国可以通过协商制定条约来限制核武器,那么在人工智能领域也应当如此。人类需要共同坐下来,为AI设立一道“防火墙”,以预防可能在100年后出现的危机。

马斯克一直关注AI的发展,他认为未来AI技术可能会被少数几家科技巨头所掌控。一旦这些公司中的某一家AI系统出现失控或偏离初衷的情况,其他公司可能也难以应对。因此,他推动了开源项目OpenAI的成立,希望通过开放源代码的方式,让更多的开发者和机构参与到AI的研发中来。他认为,如果人人都能接触到AI技术,那么整个生态就会更加平衡,也更不容易出现单点崩溃的风险。这种思路也被视为一种“美国方案”,旨在通过技术共享来降低潜在的系统性风险。

这个方案暂且不讨论好坏,但至少说明,人们已经开始认真探讨如何筑墙的问题了。

在我看来,AI这件事,如果说它像“天网”那样带来灾难未免有些夸张,但要说它完全不会带来任何风险,也还为时过早。 从当前的发展态势来看,人工智能在各个领域展现出的强大潜力令人瞩目,尤其是在医疗、交通、教育等关键行业,AI正逐步改变着我们的生活方式。然而,技术的快速发展也伴随着伦理、安全和就业等方面的挑战。我们既不能盲目乐观,也不能过度恐慌。面对AI带来的机遇与挑战,社会需要更加理性的态度和更完善的制度保障,以确保技术发展真正服务于人类福祉。

就像KK所说,我们现在正站在1984年,看着一批刚刚注册的.com域名,既感到困惑又充满期待。本世纪前半叶最伟大的事物已经展现在我们面前,只是这些令人惊叹的创新,正等待人类以远见和智慧去收获它们带来的丰硕成果。

技术爆炸的未来充满未知,而我们所有人,都是这场变革中的参与者。

人工智能最新资讯

2025-08-07 12:23:28

2025-08-07 11:52:33

2025-08-07 11:48:09

2025-08-07 11:29:18

2025-08-07 10:50:12

2025-08-07 10:48:22

2025-08-07 10:44:06

2025-08-07 10:25:55

2025-08-07 10:23:09

2025-08-07 10:20:44

2025-08-07 10:18:25

2025-08-07 10:16:45

2025-08-07 10:16:18

2025-08-07 10:15:44

2025-08-07 10:13:39

2025-08-07 10:13:24

2025-08-07 10:10:40

2025-08-07 10:10:22

2025-08-07 10:05:35

2025-08-07 10:01:20

2025-08-07 09:58:44

2025-08-04 15:56:43

2025-08-04 15:49:26

2025-08-04 15:36:51